Kako se mjeri entropija u teoriji informacija. Informaciona entropija

1. Uvod.

2. Šta je izmjerio Claude Shannon?

3. Granice evolucijske varijabilnosti informacionih sistema.

4. Ograničena adaptacija bioloških vrsta.

5. Faze razvoja teorije entropije.

6. Metode za izračunavanje količine strukturnih informacija i informacione entropije tekstova.

7. Informaciono-entropijski omjeri procesa adaptacije i razvoja.

8. Informacije i energija.

9. Zaključak.

10. Bibliografija.

UVOD

U drugoj polovini 20. veka dogodila su se dva događaja koja, po našem mišljenju, u velikoj meri određuju dalje puteve naučnog poimanja sveta. Riječ je o stvaranju teorije informacija i početku istraživanja mehanizama antientropskih procesa, za čije proučavanje sinergetika koristi sva najnovija dostignuća neravnotežne termodinamike, teorije informacija i opšte teorije sistema.

Osnovna razlika između ove faze razvoja nauke i prethodnih faza je u tome što je pre stvaranja navedenih oblasti istraživanja nauka mogla da objasni samo mehanizme procesa koji dovode do povećanja haosa i povećanja entropije. Što se tiče bioloških i evolucijskih koncepata razvijenih od vremena Lamarcka i Darwina, oni još uvijek nemaju stroga naučna opravdanja i protivreče su Drugom zakonu termodinamike, prema kojem je povećanje entropije koje prati sve procese u svijetu neophodno. fizički zakon.

Zasluga neravnotežne termodinamike leži u činjenici da je mogla otkriti mehanizme antientropijskih procesa koji nisu u suprotnosti sa Drugim zakonom termodinamike, jer se lokalno smanjenje entropije unutar samoorganizirajućeg sistema uvijek plaća. velikim porastom entropije u apsolutnoj vrijednosti spoljašnje okruženje.

Najvažniji korak ka razumijevanju prirode i mehanizama antientropskih procesa je uvođenje kvantitativne mjere informacija. U početku je ova mjera bila namijenjena samo čistom rješavanju primijenjeni zadaci komunikaciona tehnologija. Međutim, kasnija istraživanja u oblasti fizike i biologije omogućila su da se identifikuju univerzalne mjere koje je predložio K. Shannon, a koje omogućavaju uspostavljanje odnosa između količine informacija i fizičke entropije i, u konačnici, utvrđivanje suštine novog naučnog tumačenja. koncepta "informacije" kao mjere strukturnog uređenja sistema koji su najrazličitije prirode.

Koristeći metaforu, možemo reći da se prije uvođenja jedne informativne kvantitativne mjere u nauku, svijet predstavljen u prirodnonaučnim konceptima, takoreći, „oslanjao na dva kita“: energiju i materiju. “Treći kit” je sada informacija koja je uključena u sve procese koji se odvijaju u svijetu, od mikročestica, atoma i molekula do funkcionisanja najsloženijih bioloških i društvenih sistema.

Naravno, postavlja se pitanje: da li najnoviji podaci moderne nauke potvrđuju ili opovrgavaju evolucionu paradigmu nastanka života i bioloških vrsta?

Da bismo odgovorili na ovo pitanje, potrebno je prije svega razumjeti koja svojstva i aspekti višestrukog koncepta „informacije“ odražavaju kvantitativnu mjeru koju je K. Shannon uveo u nauku.

Korištenje mjere količine informacija omogućava analizu općih mehanizama informacijsko-entropijskih interakcija koji su u osnovi svih spontanih procesa akumulacije informacija u okolnom svijetu, koji dovode do samoorganizacije strukture sistema.

Istovremeno, informaciono-entropijska analiza također omogućava da se identificiraju praznine u evolucijskim konceptima, koji nisu ništa drugo do neodrživ pokušaj da se problem porijekla života i bioloških vrsta svede na jednostavne mehanizme samoorganizacije bez uzimanja u obzir činjenica da se sistemi takvog nivoa složenosti mogu kreirati samo na osnovu tih informacija, što je prvobitno bilo postavljeno u planu koji je prethodio njihovom stvaranju.

Provedeno moderna nauka proučavanja svojstava informacionih sistema daju sve razloge da se tvrdi da se svi sistemi mogu formirati samo prema pravilima koja silaze sa viših hijerarhijskih nivoa, a sama su ta pravila postojala i pre samih sistema u obliku prvobitnog plana (ideja stvaranje).

ŠTA JE MJERIO CLAUD SHANNON?

Teorija informacija zasniva se na metodi koju je predložio K. Shannon za izračunavanje količine novih (nepredvidljivih) i suvišnih (predvidljivih) informacija sadržanih u porukama koje se prenose tehničkim komunikacionim kanalima.

Metoda koju je Shannon predložio za mjerenje količine informacija pokazala se toliko univerzalnom da njena primjena više nije ograničena na uske granice čisto tehničkih aplikacija.

Suprotno mišljenju samog K. Shannon-a, koji je upozoravao naučnike na prenagljeno širenje metode koju je predložio izvan granica primijenjenih problema komunikacijske tehnologije, ova metoda je počela sve širu primjenu u proučavanjima fizičkih, bioloških i društveni sistemi.

Ključ za novo razumijevanje suštine fenomena informacije i mehanizma informacijskih procesa bio je odnos između informacije i fizičke entropije koji je uspostavio L. Brillouin. Ovaj odnos je prvobitno položen u same temelje teorije informacija, budući da je Shannon predložio korištenje vjerovatne entropijske funkcije posuđene iz statističke termodinamike za izračunavanje količine informacija.

Mnogi naučnici (počevši od samog K. Shanona) bili su skloni da takvo posuđivanje smatraju čisto formalnim sredstvom. L. Brillouin je pokazao da između količine informacija izračunate prema Šenonu i fizičke entropije ne postoji formalna, već smislena veza.

U statističkoj fizici, koristeći probabilističku funkciju entropije, proučavaju se procesi koji dovode do termodinamičke ravnoteže, u kojoj se sva stanja molekula (njihove energije, brzine) približavaju jednako vjerojatnim, a entropija teži maksimalnoj vrijednosti.

Zahvaljujući teoriji informacije postalo je očigledno da je uz pomoć iste funkcije moguće istraživati sisteme koji su daleko od stanja maksimalne entropije, kao što je, na primjer, pisani tekst.

Drugi važan zaključak je da

Koristeći probabilističku funkciju entropije, mogu se analizirati sve faze prelaska sistema iz stanja potpunog haosa, što odgovara jednake vrijednosti vjerovatnoće i maksimalnu vrijednost entropije, do stanja krajnjeg reda (rigidnog određenja), koje odgovara jedinom mogućem stanju njegovih elemenata.

Pokazalo se da je ovaj zaključak jednako istinit i za takve različite sisteme u prirodi kao što su plinovi, kristali, pisani tekstovi, biološki organizmi ili zajednice, itd.

Istovremeno, ako se za gas ili kristal pri izračunavanju entropije uporede samo mikrostanje (tj. stanje atoma i molekula) i makrostanje ovih sistema (tj. gasa ili kristala u celini), tada za sisteme različite prirode (biološke, intelektualne, socijalne) entropija se može izračunati na jednom ili drugom proizvoljno odabranom nivou. U ovom slučaju, izračunata vrednost entropije sistema koji se razmatra i količina informacija koje karakterišu stepen uređenosti ovog sistema i jednaka je razlici između maksimalne i realne vrednosti entropije zavisiće od distribucije verovatnoće stanja. elemenata osnovnog nivoa, tj. elementi koji zajedno čine ove sisteme.

Drugim riječima,

količina informacija pohranjenih u strukturi sistema proporcionalna je stepenu odstupanja sistema od stanja ravnoteže, zbog reda koji je očuvan u strukturi sistema.

Ne sluteći to, Shannon je naoružao nauku univerzalnom mjerom, u principu pogodnom (pod uslovom da se otkriju vrijednosti svih vjerovatnoća) za procjenu stepena uređenosti svih sistema koji postoje u svijetu.

Nakon što je definirao informacijsku mjeru koju je uveo Shannon kao mjera reda kretanja, moguće je uspostaviti odnos između informacije i energije, s obzirom energija je mjera intenziteta saobraćaja. Istovremeno, količina informacija pohranjenih u strukturi sistema proporcionalna je ukupnoj energiji unutrašnjih veza ovih sistema.

Istovremeno sa otkrićem zajednička svojstva informacije kao fenomen, postoje i fundamentalne razlike vezane za različite nivoe složenosti informacionih sistema.

Tako, na primjer, svi fizički objekti, za razliku od bioloških, nemaju posebne organe pamćenja, kodiranja signala koji dolaze iz vanjskog svijeta, informacijskih komunikacijskih kanala. Informacije pohranjene u njima su, takoreći, "razmazane" po njihovoj strukturi. Istovremeno, da kristali ne bi mogli pohranjivati informacije u interne veze koje određuju njihov redoslijed, ne bi bilo moguće stvoriti umjetnu memoriju i tehničke uređaje namijenjene za obradu informacija na bazi kristalnih struktura.

Istovremeno, mora se uzeti u obzir da je stvaranje takvih uređaja postalo moguće samo zahvaljujući umu osobe koja je bila u stanju da koristi elementarna informacijska svojstva kristala za izgradnju složenih informacionih sistema.

Protozoa biološki sistem nadmašuje po svojoj složenosti najnapredniji informacioni sistem koji je stvorio čovek. Već na nivou najjednostavnijih jednoćelijskih organizama aktivira se najsloženiji informacijski genetski mehanizam neophodan za njihovu reprodukciju. Kod višećelijskih organizama, pored informacioni sistem nasljednosti, postoje specijalizirani organi za pohranjivanje informacija i njihovu obradu (na primjer, sistemi koji rekodiraju vizualne i slušne signale koji dolaze iz vanjskog svijeta prije nego što ih pošalju u mozak, sistemi za obradu tih signala u mozgu). Najsloženija mreža informacionih komunikacija ( nervni sistem) prožima i pretvara cijeli višećelijski organizam u cjelinu.

Informacija i entropija

Raspravljajući o konceptu informacije, nemoguće je ne dotaknuti još jedan srodni koncept - entropiju. Po prvi put koncepte entropije i informacije povezao je K. Shannon.

| Claude Elwood Shannon ( Claude Elwood Shannon), 1916-2001 - dalji rođak Thomasa Edisona, američkog inženjera i matematičara, bio je zaposlenik Bell Laboratories od 1941. do 1972. U svom radu "Matematička teorija komunikacije" (http://cm.bell-labs. com/cm/ms /what/shanonday/), objavljen 1948. godine, prvi je odredio meru informativnog sadržaja bilo koje poruke i koncept informacionog kvanta - bit. Ove ideje su bile osnova teorije moderne digitalne komunikacije. Drugi Shanonov rad "Teorija komunikacije sistema tajnosti", objavljen 1949., doprinio je transformaciji kriptografije u naučna disciplina. On je osnivač teorija informacija, koja je našla primjenu u modernim komunikacijskim sistemima visoke tehnologije. Shannon je dao ogroman doprinos teoriji vjerojatnosnih shema, teoriji automata i teoriji sistema upravljanja - naukama koje objedinjuje koncept "kibernetike". |

Fizička definicija entropije

Po prvi put pojam entropije uveo je Clausius 1865. godine kao funkciju termodinamičkog stanja sistema.

gdje je Q toplina, T je temperatura.

Fizičko značenje entropije se manifestuje kao deo unutrašnje energije sistema, koja se ne može pretvoriti u rad. Clausius je empirijski dobio ovu funkciju eksperimentirajući s plinovima.

L. Boltzmann (1872) metodama statistička fizika izveo teorijski izraz za entropiju

gdje je K konstanta; W je termodinamička vjerovatnoća (broj permutacija molekula idealnog gasa koji ne utiče na makrostanje sistema).

Boltzmannova entropija je izvedena za idealni gas i tretira se kao mjera nereda, mjera haosa u sistemu. Za idealan gas, Entropije Boltzmanna i Klauzija su identične. Boltzmanova formula postala je toliko poznata da je upisana kao epitaf na njegovom grobu. Postoji mišljenje da su entropija i haos jedno te isto. Iako entropija opisuje samo idealnih gasova, počeo se nekritički koristiti za opisivanje složenijih objekata.

Sam Boltzmann 1886. pokušao da iskoristi entropiju da objasni šta je život. Prema Boltzmannu, život je fenomen koji može smanjiti svoju entropiju. Prema Boltzmannu i njegovim sljedbenicima, svi procesi u Univerzumu se mijenjaju u pravcu haosa. Univerzum ide ka toplotnoj smrti. Ova sumorna prognoza je dugo dominirala naukom. Međutim, produbljivanje znanja o okolnom svijetu postupno je uzdrmalo ovu dogmu.

Klasici nisu povezivali entropiju sa informacijom.

Entropija kao mjera informacije

Imajte na umu da se koncept "informacija" često tumači kao "informacija", a prijenos informacija se vrši uz pomoć komunikacije. K. Shannon je smatrao entropiju mjerom korisne informacije u procesima prenosa signala preko žica.

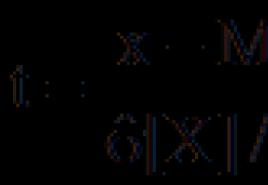

Da bi izračunao entropiju, Shannon je predložio jednačinu koja liči na klasični izraz za entropiju koji je pronašao Boltzmann. Smatramo nezavisnim slučajnim događajem x sa N mogućih stanja i p i -vjerovatnošću i-tog stanja. Zatim entropija događaja x

Ova veličina se još naziva i prosječna entropija. Na primjer, možemo govoriti o prijenosu poruke na prirodnom jeziku. Kada prenosimo različita slova, prenosimo različitu količinu informacija. Količina informacija po slovu povezana je sa učestalošću upotrebe ovog slova u svim porukama formiranim na jeziku. Što je rjeđe pismo koje prenosimo, to sadrži više informacija.

Vrijednost

H i = P i log 2 1/P i = -P i log 2 P i ,

se naziva privatnom entropijom koja karakteriše samo i-to stanje.

Objasnimo primjerima. Prilikom bacanja novčića ispadnu glava ili rep, to je određena informacija o rezultatima bacanja.

Objasnimo primjerima. Prilikom bacanja novčića ispadnu glava ili rep, to je određena informacija o rezultatima bacanja.

Za novčić, broj jednakovjerovatnih mogućnosti je N = 2. Vjerovatnoća dobijanja glave (repa) je 1/2.

Prilikom bacanja kocke dobijamo informaciju o gubitku određenog broja bodova (na primjer, tri). Kada ćemo dobiti više informacija?

Za kockicu, broj jednako vjerovatnih mogućnosti je N = 6. Vjerovatnoća da se dobije tri boda kockice je 1/6. Entropija je 2,58. Implementacija manje vjerovatnog događaja daje više informacija. Što je veća neizvjesnost prije primanja poruke o događaju (bacanje novčića, kockice), više informacija dolazi kada se poruka primi.

Ovaj pristup kvantitativnom izražavanju informacija daleko je od univerzalnog, budući da usvojene jedinice ne uzimaju u obzir tako važna svojstva informacije kao što su njena vrijednost i značenje. Apstrakcija od specifičnih svojstava informacija (njenog značenja, vrijednosti) o stvarnim objektima, kako se kasnije pokazalo, omogućila je identifikaciju opšti obrasci informacije. Jedinice (bitovi) koje je predložio Shannon za mjerenje količine informacija pogodne su za procjenu bilo koje poruke (rođenje sina, rezultati sportske utakmice, itd.). Potom su se pokušavale pronaći takve mjere količine informacija koje bi uzele u obzir njihovu vrijednost i značenje. Međutim, univerzalnost je odmah izgubljena: za različite procese kriteriji vrijednosti i značenja su različiti. Osim toga, definicije značenja i vrijednosti informacije su subjektivne, dok je mjera informacija koju predlaže Shannon objektivna. Na primjer, miris nosi ogromnu količinu informacija za životinju, ali je nedostižan za ljude. Ljudsko uho ne percipira ultrazvučne signale, ali oni nose mnogo informacija za delfina itd. Stoga je mjera informacija koju predlaže Shannon pogodna za proučavanje svih vrsta informacijskih procesa, bez obzira na "ukus" informacija potrošača.

Measuring Information

Iz kursa fizike to znate prije nego što izmjerite vrijednost bilo kojeg fizička količina, unesite mjernu jedinicu. Informacija također ima takvu jedinicu - malo, ali je njeno značenje različito za različite pristupe definiciji pojma "informacije".

Postoji nekoliko različitih pristupa problemu mjerenja informacija.

“Informacije su oblik života”, napisao je američki pjesnik i esejista John Perry Barlow. Zaista, stalno nailazimo na riječ "informacija" - ona se prima, prenosi i pohranjuje. Saznajte vremensku prognozu ili rezultat fudbalske utakmice, sadržaj filma ili knjige, razgovarajte telefonom - uvijek je jasno s kakvom informacijom imamo posla. Ali šta je sama informacija, i što je najvažnije – kako se može izmeriti, obično niko ne razmišlja. U međuvremenu, informacije i načini njihovog prenošenja su važna stvar koja u velikoj mjeri određuje naš život, čiji su sastavni dio postali informacione tehnologije. Naučni urednik Laba.Media Vladimir Gubailovski objašnjava šta su informacije, kako ih meriti i zašto je najteže preneti informacije bez izobličenja.

Prostor slučajnih događaja

Godine 1946. američki statističar John Tukey predložio je naziv BIT (BIT, BInary digiT - "binarni broj" - "Hi-tech") - jedan od glavnih koncepata 20. stoljeća. Tukey je odabrao bit da označi jednu binarnu cifru koja može da preuzme vrijednost 0 ili 1. Claude Shannon, u svom glavnom radu "Matematička teorija komunikacije", predložio je mjerenje količine informacija u bitovima. Ali ovo nije jedini koncept koji je Shannon uveo i istražio u svom radu.

Zamislite prostor nasumičnih događaja koji se sastoji od bacanja jednog lažnog novčića s glavama na obje strane. Kada pada orao? Jasno je da uvek. To znamo unaprijed, jer je tako uređen naš prostor. Dobijanje glava je određeni događaj, odnosno njegova vjerovatnoća je 1. Koliko ćemo informacija prijaviti ako kažemo o palim glavama? br. Količina informacija u takvoj poruci smatrat ćemo 0.

Sada bacimo ispravan novčić: ima glavu na jednoj strani i rep na drugoj, kako i treba da bude. Dobivanje glave ili repa bit će dva različita događaja koji čine naš prostor nasumičnih događaja. Ako prijavimo ishod jednog bacanja, onda će to zaista biti nova informacija. Na glavama ćemo prijaviti 0, a na repovima ćemo prijaviti 1. Da bismo prijavili ovu informaciju, potreban nam je samo 1 bit.

Šta se promijenilo? U našem prostoru događaja pojavila se neizvjesnost. Imamo šta da kažemo o tome nekome ko sam ne baci novčić i ne vidi ishod bacanja. Ali da bi pravilno razumio našu poruku, mora tačno znati šta radimo, šta znače 0 i 1. Naši prostori događaja se moraju podudarati, a proces dekodiranja mora nedvosmisleno povratiti rezultat bacanja. Ukoliko se prostor događaja odašiljanja i prijema ne podudara ili ne postoji mogućnost nedvosmislenog dekodiranja poruke, informacija će ostati samo šum u komunikacijskom kanalu.

Ako se dva novčića bacaju nezavisno i istovremeno, tada će biti četiri podjednako vjerovatna ishoda: glava-glava, glava-rep, rep-glava i rep-rep. Za prijenos informacija potrebna su nam već 2 bita, a naše poruke će biti sljedeće: 00, 01, 10 i 11. Informacija je postalo duplo više. To se dogodilo jer se neizvjesnost povećala. Ako pokušamo da pogodimo ishod takvog dvostrukog bacanja, duplo je veća vjerovatnoća da ćemo pogriješiti.

Što je veća nesigurnost prostora događaja, to više informacija sadrži poruka o njegovom stanju.

Hajde da malo zakomplikujemo naš prostor za događaje. Do sada su svi događaji koji su se desili bili podjednako vjerovatni. Ali u realnim prostorima, nemaju svi događaji jednaku vjerovatnoću. Recimo da je vjerovatnoća da će vrana koju vidimo biti crna blizu 1. Vjerovatnoća da će prvi prolaznik kojeg sretnemo na ulici biti muškarac je oko 0,5. Ali sresti krokodila na ulicama Moskve je gotovo nevjerovatno. Intuitivno razumijemo da poruka o susretu s krokodilom ima mnogo veću informativnu vrijednost nego o crnoj vrani. Što je manja vjerovatnoća događaja, to je više informacija u poruci o takvom događaju.

Neka prostor događaja ne bude tako egzotičan. Samo stojimo na prozoru i gledamo automobile koji prolaze. Prolaze automobili četiri boje, koje moramo prijaviti. Da bismo to učinili, kodiramo boje: crna - 00, bijela - 01, crvena - 10, plava - 11. Da bismo prijavili koji je automobil prošao, samo trebamo prenijeti 2 bita informacija.

Ali gledajući automobile dosta dugo, primjećujemo da je boja automobila neravnomjerno raspoređena: crna - 50% (svake sekunde), bijela - 25% (svaka četvrta), crvena i plava - po 12,5% ( svaki osmi). Tada možete optimizirati prenesene informacije.

Većina automobila je crna, pa nazovimo crnu - 0 - najkraći kod, a kod svih ostalih neka počinje od 1. Od preostale polovine, bijele - 10, a preostale boje počinju od 11. Konačno, hajde da pozovite crvenu - 110, a plavu - 111.

Sada, prenoseći informacije o boji automobila, možemo ih gušće kodirati.

Entropija prema Šenonu

Neka se naš prostor događaja sastoji od n različitih događaja. Prilikom bacanja novčića sa dvije glave, postoji tačno jedan takav događaj, kada se baci jedan ispravan novčić - 2, kada se bacaju dva novčića ili gledate automobile - 4. Svaki događaj odgovara vjerovatnoći njegovog nastanka. Kada je novčić bačen sa dve glave, postoji samo jedan događaj (glave) i njegova verovatnoća je p1 = 1. Kada je bačen ispravan novčić, postoje dva događaja, podjednako su verovatna i verovatnoća za svaki je 0,5: p1 = 0,5, p2 = 0,5. Prilikom bacanja dva ispravna novčića postoje četiri događaja, svi su jednako vjerovatni i vjerovatnoća svakog je 0,25: p1 = 0,25, p2 = 0,25, p3 = 0,25, p4 = 0,25. Prilikom posmatranja automobila postoje četiri događaja, koji imaju različite vjerovatnoće: crni - 0,5, bijeli - 0,25, crveni - 0,125, plavi - 0,125: p1 = 0,5, p2 = 0,25, p3 = 0,125, p4 = 0,125.

Ovo nije slučajnost. Shannon je odabrala entropiju (mjeru nesigurnosti u prostoru događaja) na takav način da su ispunjena tri uslova:

- 1 Entropija određenog događaja sa vjerovatnoćom 1 je 0.

- Entropija dva nezavisna događaja jednaka je zbiru entropija ovih događaja.

- Entropija je maksimalna ako su svi događaji podjednako vjerovatni.

Svi ovi zahtjevi sasvim su u skladu s našim idejama o neizvjesnosti prostora događaja. Ako postoji samo jedan događaj (prvi primjer), nema neizvjesnosti. Ako su događaji nezavisni - nesigurnost sume jednaka je zbiru neizvjesnosti - oni se samo zbrajaju (primjer bacanja dva novčića). I, konačno, ako su svi događaji podjednako vjerovatni, tada je stepen neizvjesnosti sistema maksimalan. Kao i u slučaju bacanja dva novčića, sva četiri događaja su podjednako verovatna i entropija je 2, što je veće nego u slučaju automobila, kada postoje i četiri događaja, ali imaju različite verovatnoće - u ovom slučaju entropija je 1,75.

Vrijednost H igra centralnu ulogu u teoriji informacija kao mjera količine informacija, izbora i neizvjesnosti.

Claude Shannon

Claude Elwood Shannon- američki inženjer, kriptoanalitičar i matematičar. Smatra se "ocem informatičkog doba". Osnivač teorije informacija, koja je našla primjenu u modernim komunikacijskim sistemima visoke tehnologije. Dao je temeljne koncepte, ideje i njihove matematičke formulacije, koje trenutno čine osnovu za moderne komunikacijske tehnologije.

Godine 1948. predložio je korištenje riječi "bit" za najmanju jedinicu informacija. Takođe je pokazao da je entropija koju je uveo ekvivalentna mjeri nesigurnosti informacija u prenesenoj poruci. Šenonovi članci "Matematička teorija komunikacije" i "Teorija komunikacije u tajnim sistemima" smatraju se fundamentalnim za teoriju informacija i kriptografiju.

Tokom Drugog svetskog rata, Shannon je razvio kriptografske sisteme u Bell Laboratories, koji su mu kasnije pomogli da otkrije metode kodiranja za ispravljanje grešaka.

Shannon je dao ključne doprinose teoriji probabilističkih shema, teoriji igara, teoriji automata i teoriji upravljačkih sistema - oblasti nauke uključene u koncept "kibernetike".

Kodiranje

I bačeni novčići i automobili u prolazu nisu kao brojevi 0 i 1. Da bi se komunicirali događaji koji se dešavaju u prostorima, potrebno je smisliti način da se ti događaji opisuju. Ovaj opis se naziva kodiranje.

Poruke se mogu kodirati neograničeno Različiti putevi. Ali Shannon je pokazao da najkraći kod ne može biti manji u bitovima od entropije.

Zato je entropija poruke mjera informacije u poruci. Pošto je u svim razmatranim slučajevima broj bitova u kodiranju jednak entropiji, to znači da je kodiranje bilo optimalno. Ukratko, više nije moguće kodirati poruke o događajima u našim prostorima.

Sa optimalnim kodiranjem, niti jedan preneseni bit ne može biti izgubljen ili izobličen u poruci. Ako se izgubi barem jedan bit, tada će informacija biti iskrivljena. Ali svi stvarni komunikacijski kanali ne daju 100% sigurnost da će svi bitovi poruke doći do primaoca neiskrivljeni.

Da biste otklonili ovaj problem, potrebno je učiniti kod ne optimalnim, već redundantnim. Na primjer, prenijeti zajedno s porukom njen kontrolni zbroj - posebno izračunatu vrijednost dobivenu pretvaranjem koda poruke, a koja se može provjeriti ponovnim izračunavanjem prilikom prijema poruke. Ako se prenesena kontrolna suma poklapa sa izračunatom, vjerovatnoća da je prijenos prošao bez grešaka bit će prilično visoka. A ako se kontrolni zbroj ne podudara, onda morate zatražiti ponovni prijenos. Tako većina komunikacijskih kanala danas funkcionira, na primjer, kada se prenose paketi informacija preko Interneta.

Poruke prirodnog jezika

Razmotrite prostor događaja koji se sastoji od poruka na prirodnom jeziku. Ovo je poseban slučaj, ali jedan od najvažnijih. Događaji će ovdje biti preneseni znakovi (slova fiksne abecede). Ovi znakovi se javljaju u jeziku sa različitom vjerovatnoćom.

Najčešći simbol (odnosno onaj koji se najčešće nalazi u svim tekstovima napisanim na ruskom) je razmak: od hiljadu znakova, prosječan razmak se pojavljuje 175 puta. Drugi po učestalosti je simbol “o” - 90, zatim ostali samoglasnici: “e” (ili “ë” - nećemo ih razlikovati) - 72, “a” - 62, “i” - 62, i samo dalje se javlja prvi suglasnik "t" je 53. A najrjeđi "f" - ovaj simbol se pojavljuje samo dva puta na hiljadu znakova.

Koristit ćemo abecedu ruskog jezika od 31 slovo (ne razlikuje se između "e" i "e", kao ni "b" i "b"). Kada bi se sva slova našla u jeziku sa istom vjerovatnoćom, onda bi entropija po znaku bila H = 5 bita, ali ako uzmemo u obzir stvarne frekvencije znakova, onda će entropija biti manja: H = 4,35 bita. (Ovo je skoro dva puta manje nego kod tradicionalnog kodiranja, kada se karakter prenosi kao bajt - 8 bita).

Ali entropija karaktera u jeziku je još niža. Verovatnoća pojavljivanja sledećeg znaka nije u potpunosti određena prosečnom učestalošću karaktera u svim tekstovima. Koji znak slijedi ovisi o znakovima koji su već preneseni. Na primjer, u modernom ruskom, iza simbola "ʺ" ne može slijediti simbol suglasničkog zvuka. Nakon dva uzastopna samoglasnika "e", treći samoglasnik "e" je izuzetno rijedak, osim u riječi "dugi vrat". Odnosno, sljedeći lik je donekle unaprijed određen. Ako uzmemo u obzir takvo predodređenje sljedećeg simbola, nesigurnost (tj. informacija) sljedećeg simbola bit će čak manja od 4,35. Prema nekim procjenama, sljedeći znak u ruskom jeziku unaprijed je određen strukturom jezika za više od 50%, odnosno, uz optimalno kodiranje, sve informacije mogu se prenijeti brisanjem polovine slova iz poruke.

Druga stvar je da se svako slovo ne može bezbolno precrtati. Visokofrekventni "o" (i samoglasnici općenito), na primjer, lako je precrtati, ali rijetki "f" ili "e" su prilično problematični.

Prirodni jezik na kojem međusobno komuniciramo je vrlo suvišan, a samim tim i pouzdan, ako smo nešto propustili - ne bojte se, informacije će se ipak prenijeti.

Ali sve dok Shannon nije uvela mjeru informacija, nismo mogli razumjeti da je jezik suvišan i do koje mjere možemo komprimirati poruke (i zašto se tekstualne datoteke tako dobro komprimiraju od strane arhivatora).

Redundantnost prirodnog jezika

U članku "O tome kako pišemo tekst" (naslov zvuči upravo tako!) Fragment romana Ivana Turgenjeva " Noble Nest” i podvrgnuto nekoj transformaciji: 34% slova je izbrisano iz fragmenta, ali ne nasumično. Prvo i posljednje slovo u riječima su ostavljeni, samo su samoglasnici izbrisani, i to ne svi. Cilj nije bio samo povratiti sve informacije iz pretvorenog teksta, već i osigurati da osoba koja čita ovaj tekst nema posebnih poteškoća zbog izostavljanja slova.

Zašto je relativno lako pročitati ovaj iskvareni tekst? Zaista sadrži potrebne informacije da povratim cijele riječi. Govornik ruskog jezika ima određeni skup događaja (riječi i cijele rečenice) koje koristi za prepoznavanje. Pored toga, nosilac takođe ima na raspolaganju standardne jezičke konstrukcije koje mu pomažu da povrati informacije. Na primjer, "Ona je blaženija"- sa velikom vjerovatnoćom može se čitati kao "Bila je osjetljivija". Ali jedna fraza "Bolja je", radije će biti vraćen kao "Bila je bjelja". Budući da se u svakodnevnoj komunikaciji bavimo kanalima u kojima postoji šum i smetnje, prilično smo dobri u vraćanju informacija, ali samo onih koje već znamo unaprijed. Na primjer, fraza “Njeni đavoli nisu daleko od prijatnih, iako su se dosta treperili i spajali”čita dobro osim zadnje riječi "splls" - "spojeno". Ova riječ nije u modernom leksikonu. At brzo čitanje riječ "spls" više se čita kao "zaglavljeni zajedno", sa sporim samo zbunjuje.

Digitalizacija signala

Zvuk, ili akustične vibracije, je sinusoida. To se može vidjeti, na primjer, na ekranu uređivača zvuka. Da biste precizno prenijeli zvuk, potreban vam je beskonačan broj vrijednosti - cijela sinusoida. To je moguće uz analognu vezu. On peva - slušaš, kontakt se ne prekida dok pesma traje.

Sa digitalnom komunikacijom preko kanala, možemo prenijeti samo konačan broj vrijednosti. Da li to znači da se zvuk ne može precizno prenijeti? Ispostavilo se da nije.

Različiti zvukovi su različito modulirani sinusoidi. Mi prenosimo samo diskretne vrijednosti (frekvencije i amplitude), a samu sinusoidu ne treba prenositi - može je generirati prijemni uređaj. Generira sinusoid, a na njega se primjenjuje modulacija, stvorena od vrijednosti koje se prenose preko komunikacijskog kanala. Postoje tačni principi čiji se diskretne vrijednosti moraju prenijeti tako da se zvuk na ulazu u komunikacijski kanal poklopi sa zvukom na izlazu, gdje se ove vrijednosti nadograđuju na neku standardnu sinusoidu (ovo je samo Kotelnikov teorem ).

Kotelnikova teorema (u engleskoj književnosti - Nyquist-Shannon teorema, teorema uzorkovanja)- fundamentalna izjava u području digitalne obrade signala, koja povezuje kontinuirane i diskretne signale i navodi da se "bilo koja funkcija F (t), koja se sastoji od frekvencija od 0 do f1, može kontinuirano prenositi sa bilo kojom tačnošću koristeći brojeve uzastopno kroz 1 /( 2*f1) sekunde.

Kodiranje za korekciju šuma. Hamingovi kodovi

Ako se kodirani tekst Ivana Turgenjeva prenosi nepouzdanim kanalom, iako s određenim brojem grešaka, tada će se dobiti potpuno smislen tekst. Ali ako trebamo sve prenijeti u bit, problem će biti neriješen: ne znamo koji su bitovi pogrešni, jer je greška slučajna. Čak se ni kontrolni zbir ne čuva uvijek.

Zato se danas, prilikom prijenosa podataka preko mreža, ne teži toliko optimalnom kodiranju, u kojem se u kanal može ugurati maksimalna količina informacija, koliko takvom kodiranju (očito suvišnom) u kojem se greške mogu vratiti - otprilike , kao što smo obnovili riječi u čitanju fragmenta Ivana Turgenjeva.

Postoje posebni kodovi za ispravljanje grešaka koji vam omogućavaju da povratite informacije nakon kvara. Jedan od njih je Hamingov kod. Recimo da se naš cijeli jezik sastoji od tri riječi: 111000, 001110, 100011. I izvor poruke i primalac znaju ove riječi. A znamo da se greške javljaju u komunikacijskom kanalu, ali kada se prenosi jedna riječ, ne iskrivljuje se više od jednog bita informacije.

Pretpostavimo da prvo prenesemo riječ 111000. Kao rezultat najviše jedne greške (greške koje smo istakli), može se pretvoriti u jednu od riječi:

1) 111000, 0 11000, 10 1000, 110 000, 1111 00, 11101 0, 111001 .

Kada se prenese riječ 001110, može se dobiti bilo koja od riječi:

2) 001110, 1 01110, 01 1110, 000 110, 0010 10, 00110 0, 001111 .

Konačno, za 100011 možemo dobiti:

3) 100011, 0 00011, 11 0011, 101 011, 1001 11, 10000 1, 100010 .

Imajte na umu da su sve tri liste parno disjunktne. Drugim riječima, ako se bilo koja riječ sa liste 1 pojavi na drugom kraju komunikacionog kanala, primalac sigurno zna da mu je preneta reč 111000, a ako se pojavi bilo koja reč sa liste 2, reč 001110, a sa liste 3, riječ 100011. U ovom slučaju recimo da je naš kod popravio jednu grešku.

Do popravka je došlo zbog dva faktora. Prvo, primalac zna ceo "rečnik", odnosno prostor događaja primaoca poruke je isti kao i prostor pošiljaoca poruke. Kada je kod prenet sa samo jednom greškom, izašla je reč koja nije bila u rečniku.

Drugo, riječi u rječniku su odabrane na poseban način.Čak i ako je došlo do greške, primalac ne bi mogao pobrkati jednu riječ s drugom. Na primjer, ako se rječnik sastoji od riječi "kćer", "tačka", "bump", a kada se prenese ispostavilo se da je "vochka", tada primalac, znajući da takva riječ ne postoji, nije mogao ispraviti greška - bilo koja od tri riječi bi se mogla ispostaviti kao tačna. Ako rečnik uključuje „tačku“, „daw“, „granu“ i znamo da nije dozvoljeno više od jedne greške, onda je „vočka“ očigledno „tačka“, a ne „gaka“. U kodovima za ispravljanje grešaka, riječi se biraju na takav način da su "prepoznatljive" čak i nakon greške. Jedina razlika je u tome što u kodu "abeceda" postoje samo dva slova - nula i jedan.

Redundantnost takvog kodiranja je vrlo velika, a broj riječi koje možemo prenijeti na ovaj način je relativno mali. Na kraju krajeva, iz rječnika trebamo isključiti bilo koju riječ koja u slučaju greške može odgovarati cijeloj listi koja odgovara prenesenim riječima (na primjer, riječi „kći“ i „tačka“ ne mogu biti u rječniku). Ali tačan prijenos poruke je toliko važan da se mnogo truda troši na proučavanje kodova za ispravljanje grešaka.

Senzacija

Koncepti entropije (ili neizvjesnosti i nepredvidljivosti) poruke i redundantnosti (ili predodređenosti i predvidljivosti) vrlo prirodno odgovaraju našim intuitivnim idejama o mjeri informacija. Što je poruka nepredvidljivija (što je veća njena entropija, jer je vjerovatnoća manja), to više informacija nosi. Senzacija (na primjer, susret s krokodilom na Tverskoj) je rijedak događaj, njegova predvidljivost je vrlo mala, pa je stoga vrijednost informacija visoka. Često se informacije nazivaju vijestima - porukama o događajima koji su se upravo dogodili, o kojima još uvijek ništa ne znamo. Ali ako nam otprilike istim riječima kažu šta se dogodilo drugi i treći put, redundantnost poruke će biti velika, njena nepredvidljivost će pasti na nulu, a mi jednostavno nećemo slušati, odbacujući govornika riječima " Znam, znam." Zato se mediji toliko trude da budu prvi. Upravo ta korespondencija s intuitivnim osjećajem za novinu dovodi do zaista neočekivanih vijesti i odigrala je veliku ulogu u činjenici da je Shanonov članak, potpuno nesmišljen za masovnog čitaoca, postao senzacija koju je pokupila štampa, koja je je prihvaćeno kao univerzalni ključ za razumevanje prirode od strane naučnika različitih specijalnosti - od lingvista i književnih kritičara do biologa.

Ali Šenonov koncept informacije je rigorozna matematička teorija, a njegova primjena izvan teorije komunikacije je vrlo nepouzdana. Ali u samoj teoriji komunikacije, ona igra centralnu ulogu.

semantičke informacije

Shannon je, uvodeći koncept entropije kao mjere informacije, dobio priliku da radi sa informacijama - prije svega, da ih izmjeri i procijeni takve karakteristike kao što su kapacitet kanala ili optimalnost kodiranja. Ali glavna pretpostavka koja je omogućila Šenonu da uspešno operiše informacijama bila je pretpostavka da je generisanje informacija slučajan proces koji se može uspešno opisati u terminima teorije verovatnoće. Ako je proces nenasumičan, to jest, pokorava se obrascima (i ne uvijek jasnim, kao što se to događa u prirodnom jeziku), onda je Šenonovo rezonovanje neprimjenjivo na njega. Sve što Shannon kaže nema nikakve veze sa smislenošću informacija.

Dokle god govorimo o simbolima (ili slovima abecede), možemo razmišljati u terminima slučajnih događaja, ali čim pređemo na riječi jezika, situacija se dramatično mijenja. Govor je proces organiziran na poseban način i ovdje struktura poruke nije ništa manje važna od simbola kojima se prenosi.

Donedavno se činilo da ne možemo ništa učiniti da se nekako približimo mjerenju smislenosti teksta, ali u poslednjih godina situacija je počela da se menja. A to je prvenstveno zbog upotrebe umjetnih neuronskih mreža za zadatke strojnog prevođenja, automatskog apstrahiranja tekstova, izdvajanja informacija iz tekstova, generiranja izvještaja na prirodnom jeziku. U svim ovim zadacima odvija se transformacija, kodiranje i dekodiranje značajnih informacija sadržanih u prirodnom jeziku. I postepeno se javlja ideja o gubicima informacija tokom takvih transformacija, a samim tim i o mjeri smislenih informacija. Ali do danas, jasnoća i tačnost koju Šenonova teorija informacija ima još uvek nisu prisutne u ovim teškim zadacima.

koncept entropija

prvi put uveo R. Clausius 1865. u termodinamiku da bi odredio mjeru ireverzibilne disipacije energije. Entropija se koristi u raznim granama nauke, uključujući teoriju informacija, kao mjera neizvjesnosti bilo kojeg iskustva, testa, koji može imati različite ishode. Ove definicije entropije imaju duboku unutrašnju vezu. Dakle, na osnovu ideja o informacijama mogu se izvesti sve najvažnije odredbe statističke fizike. [BES. fizika. M: Veliki Ruska enciklopedija, 1998].

Ova vrijednost se također naziva prosječna entropija poruke. Entropija u Šenonovoj formuli je prosečna karakteristika - matematičko očekivanje distribucija slučajna varijabla.

Na primjer, u nizu slova koji čine bilo koju rečenicu u ruskom jeziku, različita slova se pojavljuju na različitim frekvencijama, tako da je nesigurnost pojavljivanja za neka slova manja nego za druga.

Godine 1948., istražujući problem racionalnog prijenosa informacija preko bučnog komunikacijskog kanala, Claude Shannon je predložio revolucionarni probabilistički pristup razumijevanju komunikacija i stvorio prvu istinski matematičku teoriju entropije. Njegove senzacionalne ideje brzo su poslužile kao osnova za razvoj teorije informacija, koja koristi koncept vjerovatnoće. Koncept entropije, kao mjere slučajnosti, uveo je Shannon u svom članku "Matematička teorija komunikacije", objavljenom u dva dijela u Bell System Technical Journalu 1948. godine.

U slučaju jednako vjerovatnih događaja (poseban slučaj), kada su sve opcije jednako vjerovatne, ovisnost ostaje samo od broja razmatranih opcija, a Shanononova formula je uvelike pojednostavljena i poklapa se s Hartleyjevom formulom koju je prvi predložio američki inženjer Ralph Hartley 1928. godine kao jedan od naučni pristupi za procjenu poruka:

, gdje je I količina prenesene informacije, p je vjerovatnoća događaja, N je mogući broj različitih (jednako vjerovatnih) poruka.Zadatak 1. Jednako vjerovatni događaji.

U špilu se nalazi 36 karata. Koliko informacija sadrži poruka da je iz špila uzeta karta sa portretom „keca“; "kec pik"?

Vjerovatnoća p1 = 4/36 = 1/9 i p2 = 1/36. Koristeći Hartleyjevu formulu imamo:

Odgovor: 3,17; 5.17 bit

Imajte na umu (iz drugog rezultata) da je za kodiranje svih mapa potrebno 6 bitova.

Iz rezultata je također jasno da što je manja vjerovatnoća događaja, to sadrži više informacija. (Ovo svojstvo se zove monotonija)

Zadatak 2. O nejednakim događajima

U špilu se nalazi 36 karata. Od toga 12 kartica sa "portretima". Zauzvrat, jedna od karata se uzima iz špila i pokazuje da bi se utvrdilo da li je na njoj prikazan portret. Karta se vraća u špil. Odredite količinu informacija koje se prenose svaki put kada se pokaže jedna kartica.

Informaciona entropija- mjera nesigurnosti ili nepredvidivosti određenog sistema (u statističkoj fizici ili teoriji informacija), posebno, nesigurnost izgleda bilo kojeg simbola primarnog alfabeta. U drugom slučaju, u nedostatku gubitka informacija, entropija je numerički jednaka količini informacija po simbolu prenesene poruke.

Na primjer, u nizu slova koji čine bilo koju rečenicu u ruskom jeziku, različita slova se pojavljuju na različitim frekvencijama, tako da je nesigurnost pojavljivanja za neka slova manja nego za druga. Ako uzmemo u obzir da su neke kombinacije slova (u ovom slučaju govorimo o entropiji n (\displaystyle n) reda, vidi ) su vrlo rijetke, tada se nesigurnost još više smanjuje.

Koncept informacione entropije može se ilustrovati uz pomoć Maxwellovog demona. Koncepti informacija i entropije imaju duboke veze jedni s drugima [ koji?] , ali uprkos tome, razvoju teorija u statističkoj mehanici i teorije informacija bilo je potrebno mnogo godina da bi one međusobno odgovarale [ ] .

Entropija- ovo je količina informacija po elementarnoj poruci izvora koji generiše statistički nezavisne poruke.

Enciklopedijski YouTube

1 / 5

✪ Razumijevanje entropije

✪ Šta je Entropija?

✪ Entropija informacija

✪ Entropija i drugi zakon termodinamike (video 3) | Energija| Biologija

✪ Šta je entropija? Jeff Phillips #TED-Ed

Titlovi

Dakle, dali smo dvije definicije entropije kao varijable stanja. Entropija je označena slovom S. Prema termodinamičkoj definiciji, promjene entropije jednake su dodanoj toplini podijeljenoj s temperaturom na kojoj je ta toplina dodana. Međutim, ako se temperatura promijeni kako se dodaje toplina (što se obično događa), onda ćemo morati napraviti neke proračune. I ovo možete smatrati matematičkom, statističkom ili kombinatornom definicijom entropije. Prema ovoj definiciji, entropija je jednaka prirodnom logaritmu broja stanja koje sistem može zauzeti, pomnoženog sa konstantnim brojem. I u tom slučaju, sva stanja imaju istu vjerovatnoću. Ako je riječ o nezamislivo velikom broju molekula koji mogu imati još veći broj stanja, možemo pretpostaviti da će se svi razlikovati po približno jednakoj vjerovatnoći. Postoji i malo složenija definicija - za slučajeve sa vjerovatnoćom drugačijeg reda, ali sada je nećemo dirati. Sada kada smo pokrili ove dvije definicije, vrijeme je da vam kažemo o drugom zakonu termodinamike. Evo ga. Ovo je prilično jednostavan zakon, koji u isto vrijeme objašnjava vrlo širok spektar različitih pojava. Prema ovom zakonu, promjene entropije u Univerzumu tokom implementacije bilo kojeg procesa uvijek će biti veće ili jednake 0. To jest, kada se nešto dogodi u Univerzumu, rezultat toga je povećanje entropije. Ovo je veoma važan zaključak. Hajde da vidimo da li možemo da primenimo ovaj zakon na specifične situacije i na taj način shvatiti njegovo značenje. Recimo da imam dva rezervoara povezana jedan s drugim. Evo imam T1. Neka ovo bude naš rezervoar. I ovdje imamo T2. Ovo će biti hladni rezervoar. Pa, znamo iz iskustva... Šta se dešava ako posuda tople vode deli zid sa posudom sa hladnom vodom? Šta se dešava u takvom slučaju? Da, temperatura vode u njima se smanjuje. Ako govorimo o istoj supstanci, onda će se proces zaustaviti otprilike na sredini ako su u istoj fazi. Dakle, radi se o prijenosu topline sa toplije tvari na hladniju. Imamo neku toplotu, Q, koja se prenosi sa toplije supstance na hladniju. Naravno, u svakodnevnoj stvarnosti nećete vidjeti prijenos topline sa hladnije tvari na topliju. Ako stavite kocku leda u, recimo, topli čaj, onda led naravno ne postaje hladniji i čaj ne postaje topliji. Temperatura obje tvari će postati približno jednaka, odnosno čaj će u stvari dio topline dati ledu. Također je riječ o dva rezervoara, a pretpostavljam da im temperatura ostaje konstantna. Ovo se može dogoditi samo ako su oba beskonačno velika, što naravno ne postoji u stvarnom svijetu. IN stvarnom svijetu T1 će se smanjiti, a T2 povećati. Ali hajde da vidimo da li bi se to trebalo desiti, prema drugom zakonu termodinamike. Šta se ovde dešava? Kolika je promjena neto entropije za T1? Prema drugom zakonu termodinamike, promjena entropije za svemir je veća od 0. Ali u ovom slučaju jednaka je promjeni entropije za T1, plus promjena entropije za ... iako ne baš ... umjesto T1, nazovimo ga 1 ... za sistem 1, odnosno ovdje za ovaj vrući sistem plus promjena entropije za sistem 2. Dakle, kolika je promjena entropije za sistem 1? Gubi Q1 na visokoj temperaturi. Ispada minus Q (jer sistem daje toplinu) podijeljen sa T1. Zatim moramo uzeti u obzir toplinu dodanu T2 sistemu. Dakle, dodajmo Q podijeljeno sa T2. Dobijamo promjenu entropije za sistem 2, zar ne? Ovaj rezervoar, koji ima temperaturu za 1 višu, gubi toplotu. A rezervoar, koji ima nižu temperaturu 2, prima toplotu. Zar ne bi bilo veće od 0? Hajde da razmislimo malo. Ako podijelimo... dozvolite mi da to prepišem... Zapisaću na drugi način: Q podijeljeno sa T2, minus ovo. Samo preuređujem brojeve... minus Q podijeljeno sa T1. I koja je sada veća ocjena? T2 ili T1? Pa, T1 je veći, zar ne? Sada kada imamo veći rezultat... Kada koristimo riječ "viši" mislimo na određeno poređenje. Dakle, T1 je iznad ovog. Štaviše, u brojiocu u oba slučaja imamo isti broj, zar ne? Odnosno, ako uzmem, recimo, 1/2 minus 1/3, onda dobijem indikator veći od 0. Ovaj indikator je veći od ovog, jer ovaj ima veći imenilac. Dijelite sa većim brojem. O ovome vredi razmisliti. Podijelite Q ovim brojem, a zatim oduzmete Q podijeljeno većim brojem. Dakle, ovaj razlomak će ovdje imati nižu apsolutnu vrijednost. I bit će veći od 0. Prema tome, drugi zakon termodinamike potvrđuje naše zapažanje, prema kojem toplina prelazi sa vrućeg tijela na hladno. Sada možeš reći, hej Sal, mogu dokazati da nisi u pravu. Vidi se da li sam stavio klimu u sobu... Evo sobe, a evo šta je napolju. A ti kažeš – vidi šta radi klima! Već je hladno u sobi, ali je već vruće napolju. Ali šta radi klima uređaj? Hladno čini još hladnijim, a vruće još toplijim. Uzima nešto Q i kreće u ovom smjeru. zar ne? Uzima toplinu iz hladne prostorije i ispušta je u vrući zrak. I kažete da to krši drugi zakon termodinamike. Upravo ste to opovrgli. Zaslužuješ nobelova nagrada! Ali reći ću vam - zaboravljate jednu malu činjenicu. Unutar ovog klima uređaja nalazi se kompresor i motor koji aktivno rade i stvaraju takav rezultat. I ovaj motor, naglasit ću ga ružičastom bojom, također oslobađa toplinu. Nazovimo ga Q motorom. Dakle, ako želite izračunati ukupnu entropiju generiranu za cijeli univerzum, to bi bila entropija hladne sobe, plus promjena entropije za ulicu. Entropija u hladnoj sobi plus promjena entropije na otvorenom. Označimo sobu ovdje... Možete reći - u redu. Ova promjena entropije za prostoriju koja daje toplinu... recimo da soba održava konstantnu temperaturu najmanje jednu milisekundu. Prostorija daje nešto Q na određenoj temperaturi T1. I onda... morate staviti minus ovdje... onda se ulica zagrije na određenoj temperaturi T2. A vi kažete: ova cifra je manja od ove. Zato što je imenilac veći. Tada će to biti negativna entropija, i možete reći da to krši drugi zakon termodinamike. Ne! Ovdje moramo uzeti u obzir još jednu stvar: da ulica također prima toplinu od motora. Toplota iz motora podijeljena sa vanjskom temperaturom. I garantujem da će ova varijabla, neću sada iznositi brojeve, učiniti cijeli ovaj izraz pozitivnim. Ova varijabla će ukupnu neto entropiju univerzuma pretvoriti u pozitivnu. Hajde sada da razmislimo malo o tome šta je entropija u terminologiji. Na času hemije nije neuobičajeno da nastavnik kaže da je entropija jednaka neredu. Nije greška. Entropija je jednaka neredu. Ovo nije greška, jer entropija je zaista poremećaj, ali morate biti veoma oprezni sa definicijom poremećaja. Jer jedan od najčešćih primjera je: uzmite čistu sobu – recimo da vam je spavaća soba čista, ali onda postaje prljava. A oni kažu – gle, svemir je postao neuređeniji. Prljava soba ima više nereda od čiste. Ali ovo nije povećanje entropije. Dakle, ovo nije baš dobar primjer. Zašto? Da, jer čisto i prljavo su samo stanje sobe. I sjećamo se da je entropija makro varijabla stanja. koristite ga za opisi sistema kada nisi raspoložen da sjediš ovdje i kažeš mi šta tačno radi svaka čestica. I to je makro varijabla koja pokazuje koliko je vremena potrebno da mi kaže šta svaka čestica radi. Ova varijabla pokazuje koliko država postoji u ovom slučaju, ili koliko informacija o državama želim da dobijem od vas. U slučaju čiste sobe i prljave sobe, imamo samo dva različita stanja iste sobe. Ako se prostorija održava na istoj temperaturi i ima isti broj molekula i tako dalje, tada će imati istu entropiju. Dakle, kako se soba zaprlja, entropija se ne povećava. Na primjer, imam prljavu hladnu sobu. Recimo da sam ušao u ovu sobu i uložio mnogo truda da je očistim. Tako dodam dio topline u sistem, a molekuli mog znoja se raspršuju po cijeloj prostoriji - shodno tome, u njemu ima više sadržaja i postaje toplije, pretvarajući se u toplu, čistu prostoriju s kapljicama znoja. Ovaj sadržaj se može rasporediti na mnogo načina, a pošto je prostorija vruća, svaki molekul u njoj može poprimiti više stanja, zar ne? Budući da je prosječna kinetička energija visoka, može se pokušati saznati koliko kinetičkih energija svaki molekul može imati, a u potencijalu ta količina može biti prilično velika. U suštini, ovo je povećanje entropije. Od prljave, hladne sobe do tople i čiste. I to se prilično dobro uklapa u ono što znamo. Odnosno, kada uđem u sobu i počnem da je čistim, unesem toplinu u nju. A univerzum postaje sve više... Pretpostavljam da možemo reći da se entropija povećava. Dakle, gdje je ovdje zabuna? Recimo da imam loptu i ona udari o tlo i udari je. I ovdje moramo postaviti pitanje koje se stalno postavlja od otkrića prvog zakona termodinamike. Čim lopta udari o zemlju... Lopta udari o zemlju, zar ne? Bacio sam ga: u njegovom gornjem dijelu je određena potencijalna energija, koja se zatim pretvara u kinetička energija, a lopta udari o tlo i zatim se zaustavi. Tu se nameće sasvim logično pitanje – šta se desilo sa svom tom energijom? Zakon o očuvanju energije. Gdje je sve otišla? Neposredno prije nego što je udarila o tlo, lopta je imala kinetičku energiju i onda se zaustavila. Čini se da je energija nestala. Ali nije. Kada lopta padne, ima mnogo... kao što znate, sve ima svoju toplinu. Ali šta je sa zemljom? Njegovi molekuli su vibrirali određenom kinetičkom energijom i potencijalnom energijom. A onda su molekuli naše lopte počeli malo da vibriraju. Ali njihovo kretanje je bilo uglavnom naniže, zar ne? Kretanje većine molekula lopte bilo je usmjereno naniže. Kada udari o tlo, onda... dozvoli mi da nacrtam površinu lopte koja je u kontaktu sa tlom. Molekuli lopte u njenom prednjem dijelu će izgledati ovako. A ima ih dosta. Ovo solidan. Vjerovatno sa rešetkastom strukturom. A onda lopta udari o tlo. Kada se ovo desi... Zemlja je još jedno čvrsto telo... Odlično, ovde imamo mikrodržavu. Šta će se desiti? Ovi molekuli će komunicirati s njima i prenositi svoju kinetičku energiju naniže... Oni će je prenijeti na ove čestice zemlje. I suoči se s njima. I kada se, recimo, ova čestica sudari sa ovom, može se kretati u ovom pravcu. I ova će čestica početi oscilirati ovako, naprijed-nazad. Ova čestica ovdje može se odbiti od ove i kretati se u ovom smjeru, a zatim se sudariti s ovom i pomjeriti se ovdje. I onda, zato što ova čestica ovde udari, ova ovde, i pošto ova ovde, ova ovde. Sa tačke gledišta lopte, postoji relativno usmereno kretanje, ali kada dođe u kontakt sa molekulima zemlje, ona počinje da stvara kinetičku energiju i stvara kretanje u različitim pravcima. Ovaj molekul će pomeriti ovaj ovde, a ovaj će se pomeriti ovamo. Sada kretanje neće biti usmjereno ako imamo toliko molekula... označit ću ih drugom bojom... pa, ako imamo mnogo molekula i svi se kreću u potpuno istom smjeru, tada će mikrostanje izgledati kao makrostanje. Cijelo tijelo će biti u ovom pravcu. Ako imamo puno v i svi se kreću u različitim smjerovima, onda će moja lopta kao cjelina ostati na mjestu. Možemo imati istu količinu kinetičke energije molekularnom nivou , ali će se svi međusobno sudarati. I u ovom slučaju, kinetičku energiju možemo opisati kao unutrašnju energiju ili kao temperaturu, što je prosječna kinetička energija. Dakle, kada kažemo da svijet postaje sve haotičniji, mislimo na red brzina ili energija molekula. Prije nego što budu naručeni, molekuli mogu malo vibrirati, ali uglavnom će pasti. Ali kada udare o tlo, svi odmah počnu malo više vibrirati u različitim smjerovima. I zemlja također počinje da vibrira u različitim smjerovima. Dakle – na nivou mikrodržave – stvari postaju mnogo neurednije. Postoji još jedno prilično zanimljivo pitanje. Postoji još jedna mogućnost... Mogli biste pomisliti: „Vidi, ova lopta je pala i udarila o tlo. Zašto on jednostavno - zar ne bi moglo biti da sami molekuli zemlje menjaju svoj redosled tako da pravilno udaraju o molekule lopte? Postoji izvjesna vjerovatnoća da će, zbog nasumičnog kretanja, u nekom trenutku, svi molekuli zemlje jednostavno udariti molekule lopte na takav način da ona ponovo odskoči. Da, jeste. Uvek postoji beskonačno mala šansa da će se to desiti. Postoji mogućnost da će lopta samo ležati na zemlji... što je prilično interesantno... Verovatno ćete morati da čekate sto miliona godina da se ovo desi, ako se ikada desi... a lopta može jednostavno odskočiti. Postoji vrlo mala mogućnost da će ovi molekuli nasumično vibrirati na takav način da se narede na sekundu, a zatim će lopta odskočiti. Ali vjerovatnoća za to je praktično 0. Dakle, kada ljudi govore o redu i neredu, poremećaj se povećava, jer će se sada ovi molekuli kretati u različitim smjerovima i poprimiti više potencijalnih stanja. I vidjeli smo to. Kao što znate, na određenom nivou entropija izgleda kao nešto magično, ali na drugim nivoima izgleda sasvim logično. U jednom snimku... Mislim da je to bio zadnji video... Imao sam puno molekula, a onda je tu bio dodatni prostor, nakon čega sam uklonio zid. I vidjeli smo da su ti molekuli... jasno je da su postojali neki molekuli koji su se ranije odbijali od ovog zida, jer je postojao određeni pritisak povezan s tim. Zatim, čim uklonimo ovaj zid, molekuli koji bi ga udarili nastaviće da se kreću. Ništa ih ne može zaustaviti. Kretanje će se odvijati u ovom pravcu. Mogu se sudarati sa drugim molekulima i sa ovim zidovima. Ali što se ovog smjera tiče, vjerovatnoća sudara, posebno za ove molekule, je u osnovi 0. Stoga će doći do širenja i punjenja posude. Dakle, sve je sasvim logično. Ali što je najvažnije, drugi zakon termodinamike, kao što smo vidjeli u ovom videu, govori istu stvar. To jest, da će se molekuli kretati i puniti posudu. I malo je vjerovatno da će se svi oni vratiti u uređeno stanje. Naravno, postoji određena mogućnost da se, nasumično kretanjem, vrate u ovu poziciju. Ali ova vjerovatnoća je vrlo, vrlo mala. Štaviše, i to želim da naglasim, S je makro stanje. Nikada ne govorimo o entropiji u odnosu na jedan molekul. Ako znamo šta radi pojedinačna molekula, ne moramo da brinemo o entropiji. Moramo razmišljati o sistemu kao cjelini. Dakle, ako pogledamo cijeli sistem i zanemarimo molekule, nećemo znati šta se zaista dogodilo. U ovom slučaju možemo obratiti pažnju samo na statistička svojstva molekula. Koliko molekula imamo, koja je njihova temperatura, njihova makrodinamika, pritisak... i znate šta? Kontejner u koji se nalaze ovi molekuli ima više stanja od manje posude sa zidom. Čak i ako se odjednom svi molekuli nasumično skupe ovdje, nećemo znati da se to dogodilo, jer ne gledamo mikrostanja. I ovo je veoma važno imati na umu. Kada neko kaže da prljava soba ima veću entropiju od čiste, moramo shvatiti da govori o mikrostanjima. A entropija je, prije svega, koncept povezan s makrostanjem. Možete jednostavno reći da soba ima određenu količinu entropije. Odnosno, koncept entropije je vezan za prostoriju u cjelini, ali će biti koristan samo kada ne znate tačno šta se u njoj dešava. Imate samo najviše opšta ideja o tome čime je prostorija ispunjena, koja je temperatura u njoj, koji pritisak. Ovo su sve uobičajena svojstva makroa. Entropija će nam reći koliko makrostanja ovaj makrosistem može imati. Ili koliko informacija, na kraju krajeva, postoji koncept informacijske entropije, koliko informacija imam da vam pružim da biste dobili tačnu predstavu o mikrostanju sistema u odgovarajućem trenutku. Kao to. Nadam se da vam je ova rasprava bila od neke pomoći i razjasnila neke zablude o entropiji, kao i da vam je pomogla da steknete predstavu o tome šta ona zapravo jeste. Do sljedećeg videa!

Formalne definicije

Informativno binarna entropija za nezavisne slučajne događaje x (\displaystyle x) With n (\displaystyle n) moguća stanja raspoređena sa vjerovatnoćama ( i = 1 , . . . , n (\displaystyle i=1,...,n)), izračunava se po formuli

H (x) = − ∑ i = 1 n p i log 2 p i . (\displaystyle H(x)=-\suma _(i=1)^(n)p_(i)\log _(2)p_(i).)Ova vrijednost se također naziva prosječna entropija poruke. Vrijednost H i = − log 2 p i (\displaystyle H_(i)=-\log _(2)(p_(i))) pozvao privatna entropija samo karakterizira i (\displaystyle i)-e država. Općenito, baza logaritma u definiciji entropije može biti sve veća od 1; njegov izbor određuje jedinicu entropije. Dakle, često (na primjer, u problemima matematičke statistike) može biti zgodnije koristiti prirodni logaritam.

Dakle, entropija sistema x (\displaystyle x) je zbir sa suprotnim predznakom svih relativnih frekvencija pojavljivanja stanja (događaja) sa brojem i (\displaystyle i), pomnoženo njihovim vlastitim binarnim logaritmima . Ova definicija za diskretne slučajne događaje može se formalno proširiti na kontinuirane distribucije dato gustinom distribucijom vjerojatnosti , međutim, rezultirajući funkcional će imati nešto drugačija svojstva (vidi diferencijalna entropija).

Definicija prema Šenonu

Definicija Šenonove entropije povezana je sa konceptom termodinamičke entropije. Boltzmann i Gibbs su odradili odličan posao statistička termodinamika, što je doprinijelo usvajanju riječi "entropija" u teoriji informacija. Postoji veza između termodinamičke i informacione entropije. Na primjer, Maxwellov demon također suprotstavlja termodinamičku entropiju informacije, a stjecanje bilo koje količine informacija jednako je izgubljenoj entropiji.

Definicija korištenjem vlastitih informacija

Također je moguće odrediti entropiju slučajne varijable tako što ćete prvo uvesti koncepte distribucije slučajne varijable X (\displaystyle X), koji ima konačan broj vrijednosti:

P X (x i) = p i , p i ≥ 0 , i = 1 , 2 , … , n (\displaystyle P_(X)(x_(i))=p_(i),\quad p_(i)\geqslant 0,\ ;i=1,\;2,\;\ldots ,\;n) ∑ i = 1 n p i = 1 (\displaystyle \sum _(i=1)^(n)p_(i)=1) I (X) = − log P X (X) . (\displaystyle I(X)=-\log P_(X)(X).)Tada se entropija definira kao:

H (X) = E (I (X)) = − ∑ i = 1 n p (i) log p (i) . (\displaystyle H(X)=E(I(X))=-\suma _(i=1)^(n)p(i)\log p(i).)Jedinica mjerenja količine informacija i entropije ovisi o bazi logaritma: bit, nat, trit ili hartley.

Svojstva

Entropija je veličina definisana u kontekstu vjerovatnog modela za izvor podataka. Na primjer, bacanje novčića ima entropiju:

Izvor koji generiše niz koji se sastoji samo od slova "A" ima nultu entropiju: − ∑ i = 1 ∞ log 2 1 = 0 (\displaystyle -\sum _(i=1)^(\infty )\log _(2)1=0), i količinu moguća stanja jednako: 2 0 = 1 (\displaystyle 2^(0)=1) moguće stanje(vrijednost) ("A") i ne zavisi od baze logaritma.

Ovo je takođe informacija koja se takođe mora uzeti u obzir. Primjer uređaja za pohranu koji koriste bitove s entropijom jednakom nuli, ali s količina informacija jednako 1 moguće stanje, tj. različiti od nule su bitovi podataka upisani u ROM, u kojem svaki bit ima samo jedan moguće stanje.

Tako se, na primjer, može eksperimentalno utvrditi da je entropija engleski tekst je jednako 1,5 bita po karakteru, što će se naravno razlikovati za različite tekstove. Stepen entropije izvora podataka znači prosječan broj bitova po elementu podataka koji je potreban za njegovo šifriranje bez gubitka informacija, uz optimalno kodiranje.

- Neki bitovi podataka možda neće nositi informacije. Na primjer, strukture podataka često pohranjuju suvišne informacije ili imaju identične odjeljke bez obzira na informacije u strukturi podataka.

- Količina entropije nije uvijek izražena kao cijeli broj bitova.

Matematička svojstva

- Nenegativnost: H (X) ⩾ 0 (\displaystyle H(X)\geqslant 0).

- Ograničenje: H (X) = − E (log 2 p i) = ∑ i = 1 n p i log 2 1 p i = ∑ i = 1 n p i f (g i) ⩽ f (∑ i = 1 n p i g i) = log 2 n (\displaystyle H(X)=-E(\log _(2)p_(i))=\suma _(i=1)^(n)p_(i)\log _(2)(\frac (1)(p_ (i)))=\suma _(i=1)^(n)p_(i)f(g_(i))\leqslant f\left(\suma _(i=1)^(n)p_(i )g_(i)\desno)=\log _(2)n), što slijedi iz Jensenove nejednakosti za konkavnu funkciju f (g i) = log 2 g i (\displaystyle f(g_(i))=\log _(2)g_(i)) I g i = 1 p i (\displaystyle g_(i)=(\frac (1)(p_(i)))). Ako sve n (\displaystyle n) elementi iz X (\displaystyle X) jednako vjerovatno, H (X) = log 2 n (\displaystyle H(X)=\log _(2)n).

- Ako je nezavisna, onda H (X ⋅ Y) = H (X) + H (Y) (\displaystyle H(X\cdot Y)=H(X)+H(Y)).

- Entropija je naviše konveksna funkcija distribucije vjerovatnoće elemenata.

- Ako X , Y (\displaystyle X,\;Y) onda imaju istu distribuciju vjerovatnoća elemenata H (X) = H (Y) (\displaystyle H(X)=H(Y)).

Efikasnost

Abeceda može imati distribuciju vjerovatnoće daleko od uniformne. Ako originalna abeceda sadrži n (\displaystyle n) znakova, onda se može uporediti sa „optimizovanim alfabetom“, čija je distribucija verovatnoće ujednačena. Entropijski omjer originalne i optimizirane abecede je efikasnost izvorna abeceda, koja se može izraziti u procentima. Efikasnost originalne abecede sa n (\displaystyle n) znakovi se također mogu definirati kao njegovi n (\displaystyle n)-arnu entropiju.

Entropija ograničava maksimalnu moguću kompresiju bez gubitaka (ili gotovo bez gubitaka) koja se može realizirati korištenjem teorijski tipičnog skupa ili, u praksi, Huffmanovog kodiranja, Lempel-Ziv-Welch kodiranja ili aritmetičkog kodiranja.

Varijacije i generalizacije

b-arnu entropiju

Uglavnom b-arnu entropiju(Gdje b jednako 2, 3, ...) izvora S = (S, P) (\displaystyle (\mathcal (S))=(S,\;P)) sa originalnim pismom S = ( a 1 , … , a n ) (\displaystyle S=\(a_(1),\;\ldots,\;a_(n)\)) I diskretna distribucija vjerovatnoće P = ( p 1 , … , p n ) , (\displaystyle P=\(p_(1),\;\ldots,\;p_(n)\),) Gdje p i (\displaystyle p_(i)) je vjerovatnoća ( p i = p (a i) (\displaystyle p_(i)=p(a_(i)))), određuje se formulom:

H b (S) = − ∑ i = 1 n p i log b p i . (\displaystyle H_(b)((\mathcal (S)))=-\sum _(i=1)^(n)p_(i)\log _(b)p_(i).)Konkretno, kada b = 2 (\displaystyle b=2), dobijamo uobičajenu binarnu entropiju, mjerenu u bitovima. At b = 3 (\displaystyle b=3), dobijamo trinarnu entropiju mjerenu u tricima (jedan trit ima izvor informacija sa tri jednakovjerovatna stanja). At b = e (\displaystyle b=e), dobijamo informacije mjerene u nac.

Uslovna entropija

Ako redoslijed abecednih znakova nije nezavisan (na primjer, u francuskom, slovo “q” gotovo uvijek slijedi “u”, a iza riječi “lider” u sovjetskim novinama riječ “proizvodnja” ili “rad” se obično pratio), količina informacija koju nosi niz takvih simbola (a samim tim i entropija) je očigledno manja. Uslovna entropija se koristi za objašnjenje takvih činjenica.

Uslovna entropija Prvi red (slično za Markovljev model prvog reda) naziva se entropija za abecedu, gdje su poznate vjerovatnoće pojavljivanja jednog slova za drugim (tj. vjerovatnoće kombinacija dva slova):

H 1 (S) = − ∑ i p i ∑ j p i (j) log 2 p i (j) , (\displaystyle H_(1)((\mathcal (S)))=-\sum _(i)p_(i) \sum _(j)p_(i)(j)\log _(2)p_(i)(j),)Gdje i (\displaystyle i) je stanje ovisno o prethodnom znaku, i p i (j) (\displaystyle p_(i)(j)) je vjerovatnoća j (\displaystyle j) pod uslovom da i (\displaystyle i) je bio prethodni lik.

Na primjer, za ruski jezik bez slova "ë" H 0 = 5 , H 1 = 4.358 , H 2 = 3 , 52 , H 3 = 3 , 01 (\displaystyle H_(0)=5,\;H_(1)=4(,)358,\;H_( 2)=3(,)52,\;H_(3)=3(,)01) .

Parcijalne i opšte uslovne entropije u potpunosti opisuju gubitke informacija tokom prenosa podataka u kanalu sa šumom. Za to se koristi tzv matrice kanala. Da bi se opisali gubici na strani izvora (odnosno da je poslani signal poznat), uzima se u obzir uslovna verovatnoća da će prijemnik primiti simbol, pod uslovom da je simbol poslan. a i (\displaystyle a_(i)). U ovom slučaju, matrica kanala ima sljedeći oblik:

| b 1 (\displaystyle b_(1)) | b 2 (\displaystyle b_(2)) | … | b j (\displaystyle b_(j)) | … | b m (\displaystyle b_(m)) | |

|---|---|---|---|---|---|---|

| a 1 (\displaystyle a_(1)) | p (b 1 ∣ a 1) (\displaystyle p(b_(1)\mid a_(1))) | p (b 2 ∣ a 1) (\displaystyle p(b_(2)\mid a_(1))) | … | p (b j ∣ a 1) (\displaystyle p(b_(j)\mid a_(1))) | … | p (b m ∣ a 1) (\displaystyle p(b_(m)\mid a_(1))) |

| a 2 (\displaystyle a_(2)) | p (b 1 ∣ a 2) (\displaystyle p(b_(1)\mid a_(2))) | p (b 2 ∣ a 2) (\displaystyle p(b_(2)\mid a_(2))) | … | p (b j ∣ a 2) (\displaystyle p(b_(j)\mid a_(2))) | … | p (b m ∣ a 2) (\displaystyle p(b_(m)\mid a_(2))) |

| … | … | … | … | … | … | … |

| a i (\displaystyle a_(i)) | p (b 1 ∣ a i) (\displaystyle p(b_(1)\mid a_(i))) | p (b 2 ∣ a i) (\displaystyle p(b_(2)\mid a_(i))) | … | p (b j ∣ a i) (\displaystyle p(b_(j)\mid a_(i))) | … | p (b m ∣ a i) (\displaystyle p(b_(m)\mid a_(i))) |

| … | … | … | … | … | … | … |

| a m (\displaystyle a_(m)) | p (b 1 ∣ a m) (\displaystyle p(b_(1)\mid a_(m))) | p (b 2 ∣ a m) (\displaystyle p(b_(2)\mid a_(m))) | … | p (b j ∣ a m) (\displaystyle p(b_(j)\mid a_(m))) | … | p (b m ∣ a m) (\displaystyle p(b_(m)\mid a_(m))) |

Očigledno, vjerovatnoće locirane duž dijagonale opisuju vjerovatnoću ispravnog prijema, a zbir svih elemenata bilo kojeg reda daje 1. Gubici koji se mogu pripisati prenesenom signalu a i (\displaystyle a_(i)), opisani su u terminima parcijalne uslovne entropije:

H (B ∣ a i) = − ∑ j = 1 m p (b j ∣ a i) log 2 p (b j ∣ a i) . (\displaystyle H(B\mid a_(i))=-\suma _(j=1)^(m)p(b_(j)\mid a_(i))\log _(2)p(b_( j)\mid a_(i)).)Za izračunavanje gubitka prijenosa svih signala koristi se ukupna uvjetna entropija:

H (B ∣ A) = ∑ i p (a i) H (B ∣ a i) . (\displaystyle H(B\mid A)=\sum _(i)p(a_(i))H(B\mid a_(i)).)H (B ∣ A) (\displaystyle H(B\mid A)) znači entropiju na strani izvora, slično razmatrano H (A ∣ B) (\displaystyle H(A\mid B))- entropija sa strane primaoca: umjesto p (b j ∣ a i) (\displaystyle p(b_(j)\mid a_(i))) je svuda naznačeno p (a i ∣ b j) (\displaystyle p(a_(i)\mid b_(j)))(sabiranjem elemenata reda, možete dobiti p (a i) (\displaystyle p(a_(i))), a elementi dijagonale označavaju vjerovatnoću da je poslan upravo primljeni znak, odnosno vjerovatnoću ispravnog prijenosa).

Međusobna entropija

Međusobna entropija ili entropija unije je dizajniran da izračuna entropiju međusobno povezanih sistema (entropiju zajedničkog izgleda statistički zavisnih poruka) i označava se H (A B) (\displaystyle H(AB)), Gdje A (\displaystyle A) karakteriše predajnik, i B (\displaystyle B)- prijemnik.